Introduction

L'IA a facilité la production de contenu. Les moteurs de recherche ont rendu difficile la qualité à grande échelle.

En 2026, les plus grands échecs en matière de référencement naturel ne sont pas dus à l'utilisation de l'IA, mais à son utilisation sans structure, sans modération et sans intention claire. Les sites qui publient des centaines ou des milliers de pages générées par l'IA sont désormais confrontés à trois risques cumulés :

- Empreintes détectables de l'IA

- Cannibalisation des mots-clés et des intentions

- Classification silencieuse du spam ou désindexation

Aucun d'entre eux ne se traduit par des pénalités. Ils se traduisent par une stagnation, une volatilité ou une lente disparition.

Cet article explique comment le contenu généré par l'IA peut évoluer en toute sécurité, et précisément comment la plupart des sites se trompent.

Le contenu généré par l'IA n'est pas le problème, ce sont les modèles

Les moteurs de recherche ne pénalisent pas par défaut le contenu généré par l'IA.

Google répète régulièrement que la qualité et l'utilité du contenu importent plus que la manière dont il est produit.

Ce qui est filtré, ce sont les publications répétitives et de faible valeur.

La plateforme tout-en-un pour un référencement efficace

Derrière chaque entreprise prospère se cache une solide campagne de référencement. Mais avec d'innombrables outils et techniques d'optimisation parmi lesquels choisir, il peut être difficile de savoir par où commencer. Eh bien, n'ayez crainte, car j'ai ce qu'il vous faut pour vous aider. Voici la plateforme tout-en-un Ranktracker pour un référencement efficace.

Nous avons enfin ouvert l'inscription à Ranktracker de manière totalement gratuite !

Créer un compte gratuitOu connectez-vous en utilisant vos informations d'identification

L'IA à grande échelle crée des modèles que les humains créent rarement :

- Structures de phrases identiques

- Rythme prévisible des paragraphes

- Utilisation excessive de qualificatifs génériques

- Cadrage thématique répété

- Intention uniforme des pages

En petit volume, cela passe inaperçu. À grande échelle, cela devient évident.

Les moteurs de recherche ne détectent pas « l'IA ». Ils détectent les structures non originales à grande échelle.

À quoi ressemblent réellement les empreintes de l'IA ?

Les empreintes de l'IA ne sont pas des bizarreries stylistiques, mais des signaux systémiques.

Les modèles d'empreintes courants comprennent :

- Pages avec des plans identiques sur des dizaines d'URL

- Logique d'introduction répétitive (« Dans le paysage numérique actuel... »)

- Longueur et rythme des paragraphes cohérents

- Utilisation excessive d'un langage neutre et sans risque

- Sections FAQ prévisibles ajoutées partout

Individuellement inoffensives. Collectivement suspectes.

À grande échelle, ces modèles indiquent une automatisation sans intention.

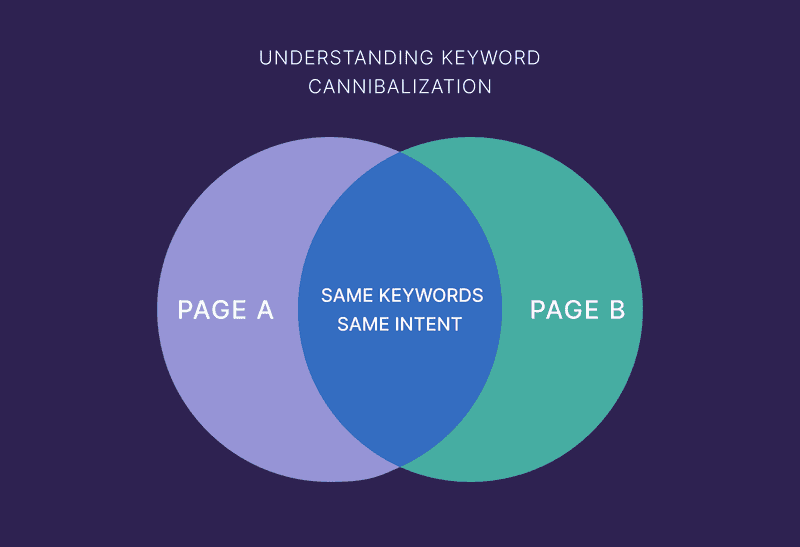

La cannibalisation est le tueur silencieux des sites d'IA

L'échec le plus courant du contenu à l'échelle de l'IA n'est pas le spam, mais l'auto-concurrence.

La cannibalisation se produit lorsque :

- Plusieurs pages ciblent le même objectif

- Les pages ne diffèrent que par leur formulation

- L'IA génère un texte « unique » pour des problèmes identiques

L'IA est excellente pour reformuler. Les moteurs de recherche sont excellents pour reconnaître les similitudes.

Pourquoi la cannibalisation est pire avec l'IA

Les rédacteurs humains ont naturellement tendance à :

- Fusionner les idées

- Approfondir

- Éviter les répétitions

L'IA ne le fait pas, sauf si on lui demande.

À grande échelle, cela conduit à :

- Répartition des impressions

- Volatilité du classement

- Rotation des pages

- Aucune page ne gagne en autorité

Pour les moteurs de recherche, cela ressemble à une confusion thématique.

La plateforme tout-en-un pour un référencement efficace

Derrière chaque entreprise prospère se cache une solide campagne de référencement. Mais avec d'innombrables outils et techniques d'optimisation parmi lesquels choisir, il peut être difficile de savoir par où commencer. Eh bien, n'ayez crainte, car j'ai ce qu'il vous faut pour vous aider. Voici la plateforme tout-en-un Ranktracker pour un référencement efficace.

Nous avons enfin ouvert l'inscription à Ranktracker de manière totalement gratuite !

Créer un compte gratuitOu connectez-vous en utilisant vos informations d'identification

En 2026, le spam est pratiquement inexistant

Oubliez les actions manuelles et les avertissements.

La classification moderne du spam ressemble à ceci :

- Ralentissement de l'indexation

- Pages ne se classant jamais

- Baisse soudaine des impressions

- Des sections entières perdent en visibilité

Pas d'alertes. Pas de messages. Juste une disparition.

Le contenu généré par l'IA déclenche les systèmes anti-spam lorsque :

- Cela n'apporte aucune nouvelle information

- Il n'existe que pour le classement

- Il répète des informations déjà connues

- Il évolue sans logique éditoriale

Le spam n'est plus une question de tromperie. Il s'agit désormais de redondance à grande échelle.

Comment adapter l'IA à grande échelle en toute sécurité

L'IA peut tout à fait être utilisée à grande échelle, à condition que le système soit correctement conçu.

1. Déployez les sujets, pas les pages

La plus grande erreur consiste à adapter les URL plutôt que la couverture.

Mauvaise approche :

- Un mot-clé → une page → des variations infinies

Approche correcte :

- Un sujet → une ressource faisant autorité → profondeur structurée

Avant de créer une nouvelle page, posez-vous la question suivante : « S'agit-il d'un nouveau problème ou simplement d'une nouvelle formulation ? »

S'il s'agit d'une formulation, consolidez.

2. Définissez l'intention avant la génération

Chaque page doit avoir une seule intention dominante:

- Informatif

- Comparatif

- Transactionnel

- Navigation

Il faut demander à l'IA de ne pas s'éloigner de cet objectif.

Les pages aux intentions multiples constituent une empreinte majeure de l'IA, car elles semblent floues et génériques.

Une intention claire conduit à :

- Meilleurs classements

- Moins de cannibalisation

- Signaux thématiques plus forts

3. Utiliser des variations de modèles avec logique

Les modèles ne sont pas mauvais. Les modèles statiques le sont.

Une mise à l'échelle sûre de l'IA nécessite :

- Sections conditionnelles

- Ordre variable

- Explications basées sur le contexte

- Différents niveaux de profondeur par page

Si toutes les pages ont le même contenu :

- En-têtes

- Nombre de sections

- Longueur des paragraphes

... vous laissez une empreinte.

La supervision humaine n'est pas facultative

L'IA doit générer des données brutes, pas des informations définitives.

L'intervention humaine est nécessaire pour :

- Décider ce qui doit exister

- Supprimer les pages redondantes

- Fusionner les intentions qui se chevauchent

- Ajouter l'expérience et la hiérarchisation

- Normaliser la terminologie

Les sites qui « publient et oublient » le contenu généré par l'IA échouent le plus rapidement.

L'IA accélère la publication. Les humains contrôlent le sens.

Les liens internes empêchent l'effondrement de l'IA

Des liens internes solides constituent l'une des meilleures d�éfenses contre les risques liés à l'IA.

Liens internes :

- Clarifier les limites des sujets

- Empêcher la cannibalisation

- Signaler la hiérarchie

- Renforcer l'autorité

Les pages sans contexte interne sont plus susceptibles d'être considérées comme jetables.

Les plateformes de référencement telles que Ranktracker aident les équipes à suivre la visibilité et les chevauchements au niveau des sujets, ce qui est essentiel lorsque le contenu généré par l'IA se développe rapidement.

Ce qu'il faut surveiller lors de la mise à l'échelle du contenu IA

Le trafic est un indicateur retardé.

La plateforme tout-en-un pour un référencement efficace

Derrière chaque entreprise prospère se cache une solide campagne de référencement. Mais avec d'innombrables outils et techniques d'optimisation parmi lesquels choisir, il peut être difficile de savoir par où commencer. Eh bien, n'ayez crainte, car j'ai ce qu'il vous faut pour vous aider. Voici la plateforme tout-en-un Ranktracker pour un référencement efficace.

Nous avons enfin ouvert l'inscription à Ranktracker de manière totalement gratuite !

Créer un compte gratuitOu connectez-vous en utilisant vos informations d'identification

Surveillez plutôt :

- Couverture de l'index par section

- Pages gagnant en impressions mais pas en classement

- Plusieurs URL classées pour la même requête

- Sections perdant simultanément en visibilité

Ce sont là les premiers signes de problèmes d'empreinte ou de cannibalisation.

Ce qui fonctionne réellement en 2026

Les contenus IA qui survivent et évoluent bien partagent des caractéristiques communes :

- Propriété thématique claire

- Pages moins nombreuses, mais plus solides

- Terminologie cohérente

- Logique éditoriale humaine

- Structure axée sur l'intention

Les sites qui échouent :

- Publier trop

- Consolider trop peu

- Laisser l'IA décider de la structure

- Mesurer le succès en fonction du volume

La règle fondamentale du contenu IA à grande échelle

Si la suppression de 30 % de votre contenu IA améliore votre site, c'est que vous avez évolué trop rapidement.

L'IA n'a pas abaissé la barre. Elle a augmenté le coût des erreurs.

Utilisée correctement, l'IA vous permet d'évoluer vers plus de clarté. Mal utilisée, elle évolue vers plus de confusion.

Les moteurs de recherche récompensent la première. Ils effacent discrètement la seconde.