引言

人工智能让内容生产变得轻松。 搜索引擎让大规模产出优质内容变得困难。

2026年,SEO最大的失败并非源于使用AI——而是源于缺乏结构、约束和明确意图的AI应用。发布数以百计甚至数千页AI生成内容的网站,如今正面临三重叠加风险:

- 可识别的AI痕迹

- 关键词与意图的相互蚕食

- 隐性垃圾信息分类或索引移除

这些风险不会以惩罚形式显现,而是表现为停滞、波动或缓慢消亡。

本文阐释了如何安全扩展AI内容——以及多数网站如何误入歧途。

问题不在于AI内容本身,而在于内容模式

搜索引擎不会默认惩罚AI生成内容。

谷歌反复强调内容质量和实用性比生产方式更重要。

真正被过滤的是模式化低价值发布。

有效SEO的一体化平台

每个成功的企业背后都有一个强大的SEO活动。但��是,有无数的优化工具和技术可供选择,很难知道从哪里开始。好了,不要再害怕了,因为我已经得到了可以帮助的东西。介绍一下Ranktracker有效的SEO一体化平台

大规模应用AI会形成人类罕见的模式:

- 句式结构雷同

- 可预测的段落节奏

- 泛泛修饰词过度使用

- 重复的主题框架

- 统一页面意图

小规模时不易察觉, 大规模时便显而易见。

搜索引擎并非检测"AI"本身, 而是识别大规模的非原创结构。

AI足迹的真实形态

AI足迹并非风格怪癖——而是系统性信号。

常见足迹模式包括:

- 数十个URL页面采用相同大纲结构

- 重复的引言逻辑("在当今数字环境中...")

- 段落长度与节奏高度一致

- 过度使用安全中立的措辞

- 千篇一律的常见问题板块遍布各处

单独看无害。 整体看可疑。

当这些模式大规模出现时,便昭示着缺乏创作意图的自动化生成。

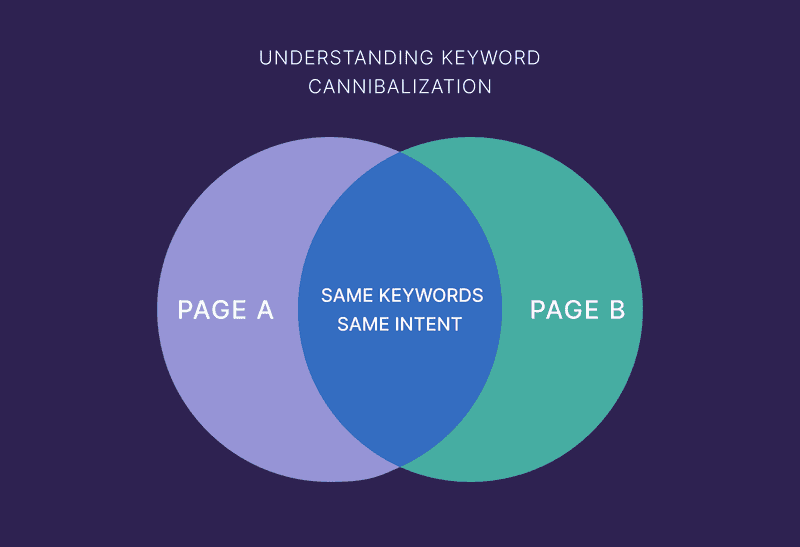

自相残杀是AI网站的无声杀手

AI规模化内容最常见的失败并非垃圾信息——而是自我竞争。

当以下情况发生时就会出现内耗:

- 多个页面针对相同用户意图

- 页面仅在措辞上存在差异

- AI为相同问题生成"独特"文本

AI擅长改写表述。 搜索引擎擅长识别内容雷同。

为何AI��时代的自我蚕食更具破坏性

人类写作者天生具备:

- 整合创意

- 深化内容层次

- 避免重复表述

AI则不会——除非被明确指示。

大规模应用时,这将导致:

- 印象分割

- 排名波动

- 页面轮换进出

- 无页面获得权威性

在搜索引擎看来,这如同主题混淆。

有效SEO的一体化平台

每个成功的企业背后都有一个强大的SEO活动。但是,有无数的优化工具和技术可供选择,很难知道从哪里开始。好了,不要再害怕了,因为我已经得到了可以帮助的东西。介绍一下Ranktracker有效的SEO一体化平台

2026年的垃圾信息大多悄无声息

手动干预和警告机制将被淘汰。

现代垃圾信息分类机制如下:

- 索引速度减缓

- 页面永不排名

- 展示量骤降

- 整版块可见度丧失

无警报。无提示。悄然消失。

当AI内容触发垃圾信息系统时:

- 未提供新见解

- 其存在仅为排名服务

- 重复已知信息

- 无编辑逻辑的规模扩张

垃圾邮件不再依赖欺骗手段。 而是通过大规模冗余传播。

如何安全扩展AI内容

只要系统设计得当,AI绝对能够实现大规模应用。

1. 扩展主题而非页面

最大的错误是扩大URL数量而非覆盖范围。

错误做法:

- 一个关键词→一个页面→无限变体

正确做法:

- 一个主题 → 一份权威资源 → 结构化深度

创建新页面前请自问: "这是否代表新问题——还是仅是表述方式不同?"

若属表述差异,则进行整合。

2. 生成前锁定意图

每个页面必须拥有单一主导意图:

- ��信息型

- 比较型

- 交易型

- 导航型

必须明确指示AI避免偏离核心意图。

意图混杂的页面会留下明显的AI痕迹,因其显得缺乏焦点且泛泛而谈。

明确意图将带来:

- 更佳排名

- 减少内部竞争

- 更强的主题信号

3. 运用逻辑化模板变体

模板本身无害,静态模板才有害。

安全的人工智能扩展需要:

- 条件性板块

- 可变排序

- 基于上下文的解释

- 每页不同深度级别

若所有页面内容雷同:

- 标题

- 章节计数

- 段落长度

……你正在留下足迹。

人工监督不可或缺

AI应生成原始素材,而非最终定论。

必须通过人工干预来:

- 确定内容构成

- 删除冗余页面

- 合并重复内容

- 添加经验与优先级排序

- 规范术语

那些"发布即遗忘"AI内容的网站,失败得最快。

AI加速内容发布。 人类掌控意义。

内部链接可防止AI崩溃

强大的内部链接是抵御AI相关风险的最佳防御手段之一。

内部链接:

- 明确主题边界

- 防止内容重叠

- 标示层级关系

- 强化权威

缺乏内部关联的页面更易被视为一次性内容。

Ranktracker等SEO平台可协助团队追踪主题层级的可见度与重叠度——当AI内容快速扩张时,这至关重要。

扩展AI内容时需监控的指标

流量属于滞后指标。

有效SEO的一体化平台

�每个成功的企业背后都有一个强大的SEO活动。但是,有无数的优化工具和技术可供选择,很难知道从哪里开始。好了,不要再害怕了,因为我已经得到了可以帮助的东西。介绍一下Ranktracker有效的SEO一体化平台

应重点关注:

- 按版面分类的索引覆盖范围

- 页面获得展示量但未提升排名

- 多个URL针对同一查询获得排名

- 多个版块同时失去可见性

这些是足迹或内耗问题的早期征兆。

2026年真正有效的策略

能够存活并实现良好扩展的人工智能内容具有共同特征:

- 明确主题归属权

- 更少但更强大的页面

- 术语保持一致

- 人工编辑逻辑

- 意图优先的结构

失败网站的特征:

- 发布过多内容

- 整合不足

- 让AI决定结构

- 以数量衡量成效

大规模AI内容的核心法则

若删除30%的AI内容能改善网站表现—— 说明扩张速度过快。

AI并未降低标准 而是提高了错误代价

正确运用AI能放大清晰度, 滥用则会放大混乱。

搜索引擎嘉奖前者, 悄然抹除后者。