Wprowadzenie

Sztuczna inteligencja ułatwiła tworzenie treści. Wyszukiwarki utrudniły zapewnienie wysokiej jakości na dużą skalę.

W 2026 r. największe porażki SEO nie będą spowodowane wykorzystaniem sztucznej inteligencji, ale jej użyciem bez struktury, ograniczeń i jasno określonych celów. Witryny publikujące setki lub tysiące stron generowanych przez sztuczną inteligencję stoją obecnie przed trzema złożonymi zagrożeniami:

- Wykrywalne ślady AI

- Kanonizacja słów kluczowych i intencji

- Cicha klasyfikacja spamu lub deindeksacja

Żadne z nich nie przejawia się w postaci kar. Przejawiają się one stagnacją, zmiennością lub powolnym zanikiem.

W tym artykule wyjaśniono, w jaki sposób treści generowane przez sztuczną inteligencję mogą być bezpiecznie skalowane — oraz w jaki sposób większość stron popełnia błędy.

Problem nie leży w treściach generowanych przez sztuczną inteligencję, ale w schematach

Wyszukiwarki nie karzą domyślnie treści generowanych przez sztuczną inteligencję.

Google wielokrotnie podkreśla, że jakość i użyteczność treści są ważniejsze niż sposób ich tworzenia.

Filtrowane są publikacje o niskiej wartości, oparte na wzorcach.

Platforma "wszystko w jednym" dla skutecznego SEO

Za każdym udanym biznesem stoi silna kampania SEO. Ale z niezliczonych narzędzi optymalizacji i technik tam do wyboru, może być trudno wiedzieć, gdzie zacząć. Cóż, nie obawiaj się więcej, ponieważ mam właśnie coś, co może pomóc. Przedstawiamy Ranktracker - platformę all-in-one dla skutecznego SEO.

W końcu otworzyliśmy rejestrację do Ranktrackera całkowicie za darmo!

Załóż darmowe kontoLub Zaloguj się używając swoich danych uwierzytelniających

Sztuczna inteligencja na dużą skalę tworzy wzorce, które ludzie rzadko stosują:

- Identyczne struktury zdań

- Przewidywalny rytm akapitów

- Nadużywanie ogólnych określeń

- Powtarzające się ramki tematyczne

- Jednolity cel strony

W niewielkich ilościach pozostaje to niezauważone. W dużej skali staje się oczywiste.

Wyszukiwarki nie wykrywają „AI”. Wykrywają one nieoryginalną strukturę na dużą skalę.

Jak naprawdę wyglądają ślady sztucznej inteligencji

Ślady AI nie są stylistycznymi dziwactwami — są to sygnały systemowe.

Typowe wzorce śladów obejmują:

- Strony o identycznym układzie w dziesiątkach adresów URL

- Powtarzająca się logika wprowadzenia („W dzisiejszym cyfrowym świecie…”)

- Jednolita długość akapitów i tempo

- Nadmierne stosowanie bezpiecznego, neutralnego języka

- Przewidywalne sekcje FAQ dodane wszędzie

Indywidualnie nieszkodliwe. W zbiorowości podejrzane.

W skali masowej wzorce te sygnalizują automatyzację bez intencji.

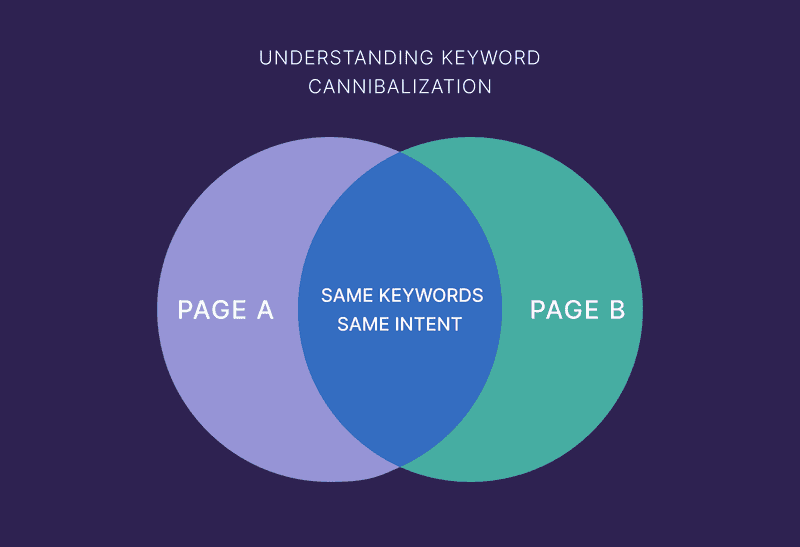

Kanonizacja jest cichym zabójcą witryn AI

Najczęstszą przyczyną niepowodzenia treści tworzonych przy użyciu sztucznej inteligencji nie jest spam, ale konkurencja wewnętrzna.

Kanibalizacja ma miejsce, gdy:

- Wiele stron ma ten sam cel

- Strony różnią się jedynie sformułowaniami

- Sztuczna inteligencja generuje „unikalny” tekst dla identycznych problemów

Sztuczna inteligencja doskonale radzi sobie z parafrazowaniem. Wyszukiwarki doskonale rozpoznają podobieństwa.

Dlaczego kanibalizacja jest gorsza w przypadku sztucznej inteligencji

Ludzie w naturalny sposób:

- Połącz pomysły

- Zwiększ głębię

- Unikaj powtarzania się

Sztuczna inteligencja tego nie robi — chyba że otrzyma takie polecenie.

W skali prowadzi to do:

- Podział wrażeń

- Zmienność rankingów

- Strony pojawiające się i znikające

- Brak stron zyskujących autorytet

Dla wyszukiwarek wygląda to jak niejasność tematu.

Platforma "wszystko w jednym" dla skutecznego SEO

Za każdym udanym biznesem stoi silna kampania SEO. Ale z niezliczonych narzędzi optymalizacji i technik tam do wyboru, może być trudno wiedzieć, gdzie zacząć. Cóż, nie obawiaj się więcej, ponieważ mam właśnie coś, co może pomóc. Przedstawiamy Ranktracker - platformę all-in-one dla skutecznego SEO.

W końcu otworzyliśmy rejestrację do Ranktrackera całkowicie za darmo!

Załóż darmowe kontoLub Zaloguj się używając swoich danych uwierzytelniających

Spam w 2026 r. jest w większości cichy

Zapomnij o ręcznych działaniach i ostrzeżeniach.

Współczesna klasyfikacja spamu wygląda następująco:

- Spowolnienie indeksowania

- Strony nigdy nie pojawiające się w rankingu

- Nagły spadek wyświetleń

- Całe sekcje tracą widoczność

Brak alertów. Brak wiadomości. Po prostu zniknięcie.

Treści generowane przez sztuczną inteligencję uruchamiają systemy antyspamowe, gdy:

- Nie dostarcza żadnych nowych informacji

- Istnieje tylko po to, aby uzyskać pozycję w rankingu

- Powtarza znane informacje

- Skalowanie bez logiki redakcyjnej

Spam nie polega już na oszukiwaniu. Chodzi o redundancję na dużą skalę.

Jak bezpiecznie skalować treści AI

Sztuczna inteligencja może być z powodzeniem stosowana na dużą skalę — pod warunkiem, że system jest prawidłowo zaprojektowany.

1. Skaluj tematy, a nie strony

Największym błędem jest skalowanie adresów URL zamiast zasięgu.

Złe podejście:

- Jedno słowo kluczowe → jedna strona → nieskończona liczba wariantów

Prawidłowe podejście:

- Jeden temat → jedno wiarygodne źródło → uporządkowana głębia

Przed utworzeniem nowej strony zadaj sobie pytanie: „Czy dotyczy to nowego problemu, czy tylko nowego sformułowania?”.

Jeśli chodzi o sformułowanie, skonsoliduj.

2. Zablokuj intencję przed generowaniem

Każda strona musi mieć jeden dominujący cel:

- Informacyjny

- Porównawcze

- Transakcyjny

- Nawigacyjne

Sztuczna inteligencja musi otrzymać instrukcję, aby nie zbaczać z kursu.

Strony o mieszanych intencjach są głównym śladem AI, ponieważ wydają się nieprecyzyjne i ogólnikowe.

Jasny cel prowadzi do:

- Lepsze rankingi

- Mniejsza kanibalizacja

- Silniejsze sygnały tematyczne

3. Użyj różnorodnych szablonów z logiką

Szablony nie są złe. Złe są szablony statyczne.

Bezpieczne skalowanie AI wymaga:

- Sekcje warunkowe

- Zmienna kolejność

- Wyjaśnienia oparte na kontekście

- Różne poziomy głębokości na stronie

Jeśli każda strona ma to samo:

- Nagłówki

- Liczba sekcji

- Długość akapitów

…pozostawiasz ślad.

Nadzór ludzki nie jest opcjonalny

Sztuczna inteligencja powinna generować surowy materiał, a nie gotowy produkt.

Interwencja człowieka jest wymagana w celu:

- Zdecyduj, co powinno się znaleźć

- Usuń zbędne strony

- Połącz powtarzające się intencje

- Dodaj doświadczenie i priorytetyzację

- Ujednolicenie terminologii

Witryny, które „publikują i zapominają” o treściach generowanych przez sztuczną inteligencję, najszybciej ponoszą porażkę.

Sztuczna inteligencja przyspiesza publikowanie. Ludzie kontrolują znaczenie.

Wewnętrzne linkowanie zapobiega załamaniu się sztucznej inteligencji

Silne linkowanie wewnętrzne jest jedną z najlepszych metod ochrony przed ryzykiem związanym ze sztuczną inteligencją.

Linki wewnętrzne:

- Wyjaśnij granice tematów

- Zapobieganie kanibalizacji

- Sygnalizuj hierarchię

- Wzmocnienie autorytetu

Strony bez kontekstu wewnętrznego są częściej traktowane jako jednorazowe.

Platformy SEO, takie jak Ranktracker, pomagają zespołom śledzić widoczność i nakładanie się tematów — co ma kluczowe znaczenie w przypadku szybkiego rozwoju treści generowanych przez sztuczną inteligencję.

Co należy monitorować podczas skalowania treści AI

Ruch jest wskaźnikiem opóźnionym.

Platforma "wszystko w jednym" dla skutecznego SEO

Za każdym udanym biznesem stoi silna kampania SEO. Ale z niezliczonych narzędzi optymalizacji i technik tam do wyboru, może być trudno wiedzieć, gdzie zacząć. Cóż, nie obawiaj się więcej, ponieważ mam właśnie coś, co może pomóc. Przedstawiamy Ranktracker - platformę all-in-one dla skutecznego SEO.

W końcu otworzyliśmy rejestrację do Ranktrackera całkowicie za darmo!

Załóż darmowe kontoLub Zaloguj się używając swoich danych uwierzytelniających

Zamiast tego należy obserwować:

- Indeksuj zasięg według sekcji

- Strony zyskujące wyświetlenia, ale nie pozycje w rankingu

- Wiele adresów URL w rankingu dla tego samego zapytania

- Sekcje tracące widoczność jednocześnie

Są to wczesne oznaki problemów związanych z odciskiem lub kanibalizacją.

Co faktycznie działa w 2026 r.

Treści AI, które przetrwały i dobrze się skalują, mają wspólne cechy:

- Wyraźna własność tematyczna

- Mniej stron, ale silniejszych

- Spójna terminologia

- Ludzka logika redakcyjna

- Struktura oparta na intencjach

Witryny, które ponoszą porażkę:

- Publikowanie zbyt dużej ilości treści

- Zbyt mała konsolidacja

- Pozwól sztucznej inteligencji decydować o strukturze

- Mierzenie sukcesu na podstawie ilości

Podstawowa zasada treści AI na dużą skalę

Jeśli usunięcie 30% treści AI poprawiłoby działanie Twojej witryny — oznacza to, że skalowałeś ją zbyt szybko.

Sztuczna inteligencja nie obniżyła poprzeczki. Podniosła koszt błędów.

Prawidłowo stosowana sztuczna inteligencja pozwala zwiększyć przejrzystość. Źle stosowana zwiększa zamieszanie.

Wyszukiwarki nagradzają pierwsze podejście. Drugie po cichu usuwają.