Hvad er LLM-optimering?

LLM-optimering er processen med at strukturere dit websites indhold, metadata og enheder, så store sprogmodeller (LLM'er) - såsom OpenAI's GPT, Google Gemini, Anthropic Claude og Mistral - nemt kan forstå, fortolke og hente oplysninger fra det.

Målet med LLM-optimering er ikke kun at forbedre synligheden i AI-drevne søgeoplevelser som Googles AI-oversigter eller Bing Copilot, men også at gøre dit brands indhold mere refererbart, når LLM'er genererer svar, resuméer eller anbefalinger.

Kort sagt hjælper LLM-optimering med at sikre, at dine oplysninger er maskinfortolkelige, faktuelt stabile og kontekstuelt rige nok til at blive brugt med tillid af AI-modeller.

Hvordan fungerer LLM-optimering?

Store sprogmodeller bruger vektorindlejringer, semantiske relationer og vidensgrafer til at forstå og gengive menneskesprog. Når du optimerer til LLM'er, tilpasser du i bund og grund dit indhold til disse datasystemer.

Sådan fungerer LLM-optimering trin for trin:

- Indlæsning af indhold: AI-crawlere eller genfindingssystemer læser dit indhold, metadata og strukturerede data.

- Semantisk indlejring: Tekst konverteres til numeriske vektorer, der repræsenterer betydning og relationer.

- Kontekstuel rangordning: LLM evaluerer relevans, klarhed og faktuel forankring baseret på omgivende enheder.

- Generering og attribuering: Når en bruger stiller et spørgsmål, henter modellen relevante indlejringer - og citerer eller parafraserer potentielt dit indhold i sit output.

Optimering til denne proces betyder at præsentere information i formater og sammenhænge, som LLM'er nemt kan analysere og stole på.

Hvorfor er LLM-optimering vigtig?

Traditionel SEO fokuserede på søgeordstilpasning og backlinks. I modsætning hertil fokuserer LLM-optimering på dataklarhed, faktuel nøjagtighed og enhedskonsistens - de elementer, der bestemmer, hvordan AI-modeller lærer, opsummerer og repræsenterer information.

1. Synlighed i AI-drevet søgning

LLM'er driver i stigende grad søgeresultater, resuméer og anbefalingsmotorer. Uden optimering risikerer dit brand at blive udeladt fra generative outputs.

2. Begrænsning af hallucinationer

Når AI-modeller ikke kan finde strukturerede eller verificerede data, genererer de ("hallucinerer") falske udsagn. Optimering sikrer, at dine oplysninger udfylder disse huller nøjagtigt.

3. Autoritet på enhedsniveau

LLM'er tænker i enheder, ikke i nøgleord. Korrekt entitetsdefinition og skemaopmærkning øger sandsynligheden for, at du bliver fundet på relaterede forespørgsler.

4. Fremtidssikring af SEO

Efterhånden som AI-systemerne udvikler sig, vil struktureret og semantisk klarhed afgøre, om dit brand fortsat kan findes i AI-drevne økosystemer.

Sådan optimerer du til LLM'er

1. Brug et klart, faktuelt sprog

Skriv entydige sætninger, og undgå overdrevent marketingsprog. LLM'er foretrækker eksplicitte fakta og definitioner, der kan verificeres.

2. Tilføj skemaopmærkning og strukturerede data

Inkluder skemaer for organisation, person, FAQ-side, produkt og how-to. JSON-LD-markup giver den maskinlæsbare klarhed, som LLM'er er afhængige af.

3. Forstærk enhedsforbindelserne

Forbind dit indhold med anerkendte databaser som Wikidata, Googles Knowledge Graph og autoritative eksterne websteder. Konsistens på tværs af platforme skaber tillid.

4. Inkluder kildehenvisninger

LLM'er prioriterer kilder med tydelig kildeangivelse. Citér statistikker, undersøgelser eller referencer direkte i din tekst, så det er nemt for søgesystemerne at vurdere troværdigheden.

5. Bevar indholdets friskhed

Opdater jævnligt dit indhold. Mange LLM'er bruger RAG-systemer (retrieval-augmented generation), der henter nyere data fra indekserede kilder.

6. Udgiv i crawlbare, tekstbaserede formater

Undgå, at kritisk information er låst inde i billeder eller scripts. Brug HTML-first-præsentation med beskrivende alt-tekst og semantisk struktur.

7. Styrk forfatter- og brandsignaler

Opbyg E-E-A-T-konsistens: Vis forfatterens referencer, verificerede sociale profiler og detaljerede organisationssider, der er linket via skema.

LLM-optimering vs. traditionel SEO

| Funktion | Traditionel SEO | LLM-optimering |

|---|---|---|

| Mål | Rangere højere på SERP'er | Blive henvist til eller hentet af AI-systemer |

| Kernefokus | Nøgleord, backlinks | Entiteter, semantik, faktuel klarhed |

| Datatype | Ustruktureret tekst | Strukturerede + semantiske data |

| Crawlere | Søgemaskine-bots | AI og indlejringsmodeller |

| Primært output | SERP-lister | AI-genererede resuméer og citater |

Teknisk grundlag for LLM-optimering

- Vektorindlejringer: Repræsenterer dit indholds betydning numerisk for AI-hentningssystemer.

- Retrieval-Augmented Generation (RAG): LLM'er henter data i realtid for at forbedre den faktuelle pålidelighed.

- Tilpasning af vidensgraf: Sikrer, at dit brand og dine enheder genkendes i AI-videnbaser.

- Kortlægning af citater: Styrker, hvordan modeller forbinder fakta med originale kilder.

- Konsistens i indhold: Reducerer tvetydighed og forbedrer indlejringsnøjagtigheden på tværs af flere domæner.

Værktøjer og teknikker

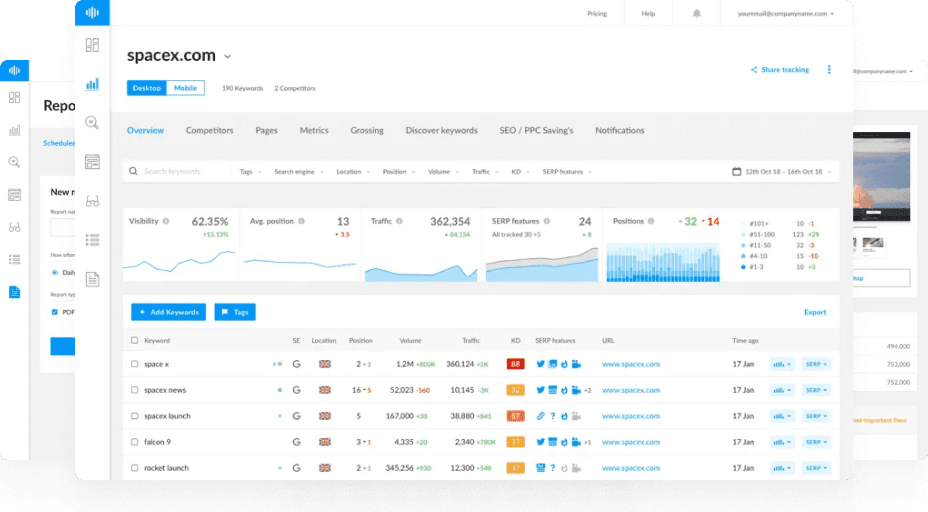

- Ranktracker Web Audit: Identificerer huller i skemaer og uoverensstemmelser mellem enheder.

- Søgeordsfinder: Opdag semantisk relaterede søgeord til kontekstrig optimering.

- AI-artikelforfatter: Producer struktureret, faktuelt indhold, der er egnet til både SEO og AI-motorer.

- SERP-kontrol: Overvåg AI-forstærkede søgefunktioner og deres indvirkning på synligheden.

Fremtiden for LLM-optimering

Efterhånden som LLM'er bliver grundlaget for de fleste digitale grænseflader - fra søgning til virtuelle assistenter - vil optimering til dem være lige så kritisk som traditionel SEO engang var.

Forvent at se:

- LLM-synlighedsanalyse (sporing af omtaler og citater).

- AI-tillidsscoring for webenheder.

- Optimering på tværs af modeller, hvor en indholdsstrategi tjener flere AI-økosystemer.

Sammenfatning

LLM-optimering er broen mellem SEO og AI. Den sikrer, at dit indhold er struktureret, faktuelt og kontekstuelt nok til at blive hentet, citeret og betroet af store sprogmodeller.

Efterhånden som AI bliver den vigtigste grænseflade for opdagelse, vil mestring af LLM-optimering afgøre, hvem der bliver refereret til - og hvem der forsvinder fra samtalen.