크롤러란 무엇인가요?

크롤러는 인터넷을 체계적으로 탐색하도록 설계된 인터넷 프로그램입니다. 크롤러는 검색 엔진이 페이지를 검색하고 처리하여 색인을 생성하고 검색 결과에 표시하기 위한 수단으로 가장 일반적으로 사용됩니다.

HTML을 처리하는 크롤러 외에도 이미지와 동영상을 색인하는 데 일부 특수 크롤러가 사용됩니다.

실제 세계에서 알아야 할 주요 웹 크롤러는 세계 최고의 검색 엔진에서 사용하는 웹 크롤러입니다: 구글봇, 빙봇, 얀덱스 봇, 바이두 스파이더 등이 있습니다.

좋은 크롤러와 나쁜 크롤러

좋은 크롤러는 주로 콘텐츠를 검색 색인에 추가하거나 웹사이트 감사를 도와주는 등 사이트에 도움을 주는 봇이라고 생각하면 됩니다. 좋은 크롤러의 다른 특징은 자신을 식별하고, 사용자의 지시를 따르며, 서버에 과부하가 걸리지 않도록 크롤링 속도를 조정한다는 점입니다.

악성 크롤러는 웹사이트 소유자에게 아��무런 가치를 제공하지 않으며 악의적인 의도를 가지고 있을 수 있는 봇입니다. 악성 크롤러는 신원 확인에 실패하고, 사용자의 지시사항을 우회하며, 서버에 불필요한 부하를 발생시키고, 심지어 콘텐츠와 데이터를 훔칠 수도 있습니다.

크롤러의 유형

크롤러에는 크게 두 가지 유형이 있습니다:

- 상시크롤링 봇: 연중무휴 24시간 크롤링을 수행하여 새 페이지를 발견하고 오래된 페이지를 다시 크롤링합니다(예: Googlebot).

- 온디맨드 봇: 제한된 수의 페이지를 크롤링하며 요청이 있을 때만 크롤링을 수행합니다(예: Ranktracker 사이트 감사 봇).

웹사이트 크롤링이 중요한 이유는 무엇인가요?

검색 엔진 크롤러의 주요 목적은 웹사이트에 무엇이 있는지 찾아서 이 정보를 검색 색인에 추가하는 것입니다. 사이트가 크롤링되지 않으면 콘텐츠가 검색 결과에 표시되지 않습니다.

웹사이트 크롤링은 일회성 이벤트가 아니라 활성 웹사이트에 대한 지속적인 작업입니다. 봇은 정기적으로 웹사이트를 다시 크롤링하여 새 페이지를 찾아 검색 색인에 추가하는 동시에 기존 페이지에 대한 정보도 업데이트합니다.

대부분의 크롤러는 검색 엔진과 연관되어 있지만, 다른 유형의 크롤러도 있습니다. 예를 들어 Ranktracker 사이트 감사 봇은 SEO 측면에서 웹사이트의 문제점을 파악하는 데 도움을 줄 수 있습니다.

크롤러는 어떻게 작동하나요?

간단히 말해, Googlebot과 같은 웹 크롤러는 사이트맵, 링크, Google Search Console을 통한 수동 제출을 통해 웹사이트의 URL을 발견합니다. 그런 다음 해당 페이지의 "허용된" 링크를 따라갑니다.

이 작업은 robots.txt 규칙과 링�크 및 개별 페이지의 모든 'nofollow' 속성을 준수하면서 수행됩니다.

정기적으로 업데이트되는 페이지가 100만 페이지가 넘는 웹사이트나 매일 변경되는 콘텐츠가 1만 페이지가 넘는 웹사이트 등 일부 웹사이트는 "크롤링 예산"이 제한되어 있을 수 있습니다. 이는 봇이 단일 세션에서 웹사이트에 투입할 수 있는 시간과 리소스의 양을 나타냅니다.

크롤링 우선순위

크롤링 예산의 용량이 제한되어 있기 때문에 크롤러는 일련의 크롤링 우선순위에 따라 작동합니다. 예를 들어 Googlebot은 다음을 고려합니다:

- URL의 페이지 순위

- 페이지가 업데이트되는 빈도

- 페이지가 새 페이지인지 여부

이렇게 하면 크롤러가 사이트에서 가장 중요한 페이지를 먼저 크롤링하는 데 집중할 수 있습니다.

모바일 크롤러 버전과 데스크톱 크롤러 버전

Googlebot에는 두 가지 주요 버전이 있습니다: 구글봇 데스크톱과 구글봇 스마트폰입니다. 현재 Google은 모바일 우선 인덱싱을 사용하므로 스마트폰 에이전트가 페이지 크롤링 및 색인 생성에 사용되는 기본 Google봇입니다.

이러한 다양한 유형의 크롤러에게 다양한 버전의 웹사이트가 제공될 수 있습니다. 기술적으로 봇은 고유 식별자와 함께 HTTP 요청 헤더 User-Agent를 사용하여 웹 서버에 자신을 식별합니다.

크롤링 친화적인 웹사이트를 위한 모범 사례

웹사이트가 크롤링할 준비가 되었는지 확인하기 위해 권장하는 몇 가지 단계가 있습니다. 주요 페이지가 색인화되고 순위를 매길 수 있는 최상의 기회를 얻으려면 이 단계를 따르세요.

1. Robots.txt 파일 확인

robots.txt 파일은 일련의 크롤러 지시문을 사용하여 해당 �봇과 통신하는 웹사이트의 파일입니다. 색인화하려는 페이지나 섹션에서 정상적인 봇을 허용하지 않는지 확인하세요. Google의 robots.txt 테스터와 같은 도구를 사용하여 오류를 확인합니다.

2. 사이트맵 제출

사이트맵 제출은 매우 중요한 단계입니다. 사이트맵에는 색인화하려는 웹사이트의 모든 페이지가 나열됩니다. Google Search Console의 색인 > 사이트맵에서 사이트맵을 제출할 수 있습니다. 이 과정은 Bing 웹마스터 도구와 같은 다른 검색 엔진에서도 비슷합니다.

3. 현명한 크롤러 지시어 사용

robots.txt 파일은 지시문을 사용하여 크롤러에게 크롤링할 수 있는 페이지와 허용되지 않는 페이지를 알려줍니다. 사이트 탐색에서 중요한 페이지가 크롤링되도록 허용하는 것이 중요합니다. robots.txt 파일에서 콘텐츠 크롤링이 허용되지 않는 경우 페이지 수준 지시어는 표시되지 않습니다.

4. 페이지 간 내부 링크 제공

내부 링크는 검색 엔진이 각 페이지의 내용을 이해하는 데 도움이 되며 크롤러가 처음에 페이지를 발견하는 데 도움이 됩니다. 또한 내부 링크는 사이트 전체에서 PageRank가 흐르는 방식을 형성하는 데 도움이 됩니다.

5. 4xx 및 불필요한 리디렉션 줄이기

4xx 오류는 해당 URL의 콘텐츠가 존재하지 않는다는 것을 크롤러에게 알립니다. 이러한 페이지를 수정하거나 라이브 페이지로 리디렉션을 설정하려면 Ranktracker 사이트 감사와 같은 도구를 사용하세요. 또한 불필요한 리디렉션과 리디렉션 체인을 제거하여 원활한 크롤링을 보장하세요.

6. Ranktracker 사이트 감사를 사용하여 크롤링 가능성 및 색인 가�능성 문제 찾기

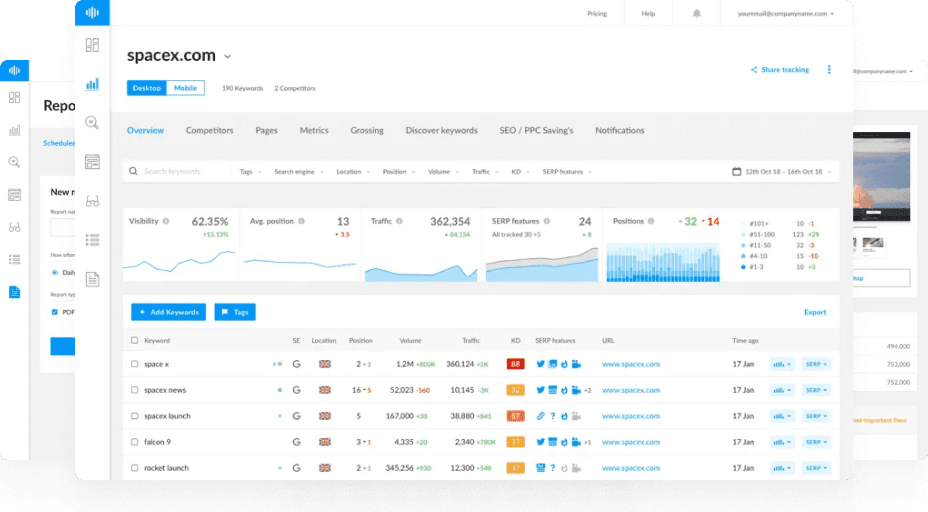

Ranktracker 사이트 감사 도구는 사이트의 색인되지 않은 페이지와 팔로우하지 않는 링크를 모두 확인하여 도움을 줄 수 있습니다. 리디렉션 체인이나 루프를 포함하여 깨진 페이지나 과도한 리디렉션을 발견하고 고아 페이지를 지적할 수 있습니다.

자주 묻는 질문

크롤링과 인덱싱은 같은 것일까요?

크롤링은 공개적으로 액세스할 수 있는 웹 페이지 및 기타 콘텐츠를 검색하는 프로세스를 말합니다. 인덱싱은 검색 엔진이 이러한 페이지를 분석하여 검색 색인에 저장하는 것을 말합니다.

가장 활동적인 크롤러는 무엇인가요?

가장 인기 있는 검색 엔진 크롤러로는 Googlebot, Bingbot, Yandex Bot, Baidu Spider 등이 있습니다. 자세한 내용은 Imperva 봇 트래픽 연구를 확인하세요. 흥미롭게도 전체 링크 데이터베이스를 구동하는 AhrefsBot이 Googlebot 다음으로 가장 활발하게 크롤링하는 것으로 나타났습니다.

크롤러가 내 웹사이트를 손상시키나요?

대부분의 크롤러는 웹사이트에 해를 끼치지는 않지만, 악성 크롤러도 있습니다. 유해한 크롤러는 대역폭을 차지하여 페이지 속도를 저하시키고 데이터를 훔치거나 사이트에서 콘텐츠를 스크랩하려고 시도할 수 있습니다.