Hva er LLM-optimalisering?

LLM-optimalisering er prosessen med å strukturere innholdet, metadataene og entitetene på nettstedet ditt slik at store språkmodeller (LLM-er) - som OpenAIs GPT, Google Gemini, Anthropic Claude og Mistral - enkelt kan forstå, tolke og hente informasjon fra det.

Målet med LLM-optimalisering er ikke bare å forbedre synligheten i AI-drevne søkeopplevelser som Googles AI-oversikter eller Bing Copilot, men også å gjøre merkevareinnholdet ditt mer referansedyktig når LLM-ene genererer svar, sammendrag eller anbefalinger.

Kort sagt bidrar LLM-optimalisering til å sikre at informasjonen din er maskintolkbar, faktastabil og kontekstrik nok til at den kan brukes trygt av AI-modeller.

Hvordan fungerer LLM-optimalisering?

Store språkmodeller bruker vektorinnbygging, semantiske relasjoner og kunnskapsgrafer for å forstå og gjengi menneskelig språk. Når du optimaliserer for LLM-er, tilpasser du innholdet ditt til disse datasystemene.

Slik fungerer LLM-optimalisering trinn for trinn:

- Innlesing av innhold: AI-crawlere eller gjenfinningssystemer leser innholdet, metadataene og strukturerte data.

- Semantisk innbygging: Tekst konverteres til numeriske vektorer som representerer mening og relasjoner.

- Kontekstuell rangering: LLM evaluerer relevans, klarhet og faktagrunnlag basert på omkringliggende enheter.

- Generering og attribusjon: Når en bruker stiller et spørsmål, henter modellen relevante innlemminger - og siterer eller parafraserer potensielt innholdet ditt i utdataene.

Optimalisering for denne prosessen innebærer å presentere informasjon i formater og sammenhenger som LLM-er enkelt kan analysere og stole på.

Hvorfor er LLM-optimalisering viktig?

Tradisjonell SEO fokuserer på søkeordjustering og tilbakekoblinger. LLM-optimalisering fokuserer derimot på dataklarhet, faktanøyaktighet og enhetskonsistens - elementene som avgjør hvordan AI-modeller lærer, oppsummerer og representerer informasjon.

1. Synlighet i AI-drevne søk

LLM-er brukes i økende grad i søkeresultater, sammendrag og anbefalingsmotorer. Uten optimalisering risikerer merkevaren din å bli utelatt fra generative resultater.

2. Redusere hallusinasjoner

Når AI-modeller ikke finner strukturerte eller verifiserte data, genererer de ("hallusinerer") falske påstander. Optimalisering sikrer at informasjonen din fyller disse hullene nøyaktig.

3. Autoritet på entitetsnivå

LLM-er tenker i entiteter, ikke nøkkelord. Riktig enhetsdefinisjon og skjemamerking øker sannsynligheten for at du blir funnet på relaterte spørsmål.

4. Fremtidssikring av SEO

Etter hvert som AI-systemene utvikler seg, vil strukturert og semantisk klarhet avgjøre om merkevaren din forblir søkbar i AI-drevne økosystemer.

Slik optimaliserer du for LLM-er

1. Bruk et klart og saklig språk

Skriv entydige setninger og unngå overdrevent markedsføringsspråk. LLM-er foretrekker eksplisitte fakta og definisjoner som kan verifiseres.

2. Legg til skjemamerking og strukturerte data

Inkluder skjemaer for organisasjon, person, FAQ-side, produkt og veiledning. JSON-LD-markering gir den maskinlesbare klarheten som LLM-er er avhengige av.

3. Forsterk entitetskoblinger

Koble innholdet ditt til anerkjente databaser som Wikidata, Googles Knowledge Graph og autoritative eksterne nettsteder. Konsistens på tvers av plattformer bygger tillit.

4. Inkluder kildehenvisninger

LLM-er prioriterer kilder med tydelig kildehenvisning. Siter statistikk, studier eller referanser direkte i teksten, slik at det blir enkelt for gjenfinningssystemer å assosiere troverdighet.

5. Oppretthold innholdets aktualitet

Oppdater innholdet ditt jevnlig. Mange LLM-er bruker RAG-systemer (retrieval-augmented generation) som henter nyere data fra indekserte kilder.

6. Publiser i gjennomsøkbare, tekstbaserte formater

Unngå at kritisk informasjon er innelåst i bilder eller skript. Bruk HTML-først-presentasjon med beskrivende alt-tekst og semantisk struktur.

7. Styrk forfatter- og merkevaresignalene

Skap E-E-A-T-konsistens: vis forfatterens legitimasjon, verifiserte sosiale profiler og detaljerte organisasjonssider som er lenket via skjema.

LLM-optimalisering kontra tradisjonell SEO

| Funksjon | Tradisjonell SEO | LLM-optimalisering |

|---|---|---|

| Mål | Ranger høyere på SERP-ene | Bli referert til eller hentet av AI-systemer |

| Kjernefokus | Nøkkelord, tilbakekoblinger | Entiteter, semantikk, faktaklarhet |

| Datatype | Ustrukturert tekst | Strukturerte + semantiske data |

| Crawlere | Søkemotorroboter | AI og innebygde modeller |

| Primært resultat | SERP-oppføringer | AI-genererte sammendrag og siteringer |

Teknisk grunnlag for LLM-optimalisering

- Vektorinnbygging: Representerer innholdets betydning numerisk for AI-hentesystemer.

- Retrieval-Augmented Generation (RAG): LLM-er henter data i sanntid for å forbedre faktapåliteligheten.

- Tilpasning av kunnskapsgrafen: Sikrer at merkevaren og enhetene dine gjenkjennes i AI-kunnskapsbaser.

- Kartlegging av sitater: Styrker hvordan modeller kobler fakta til originalkilder.

- Innholdskonsistens: Reduserer tvetydighet og forbedrer nøyaktigheten på tvers av flere domener.

Verktøy og teknikker

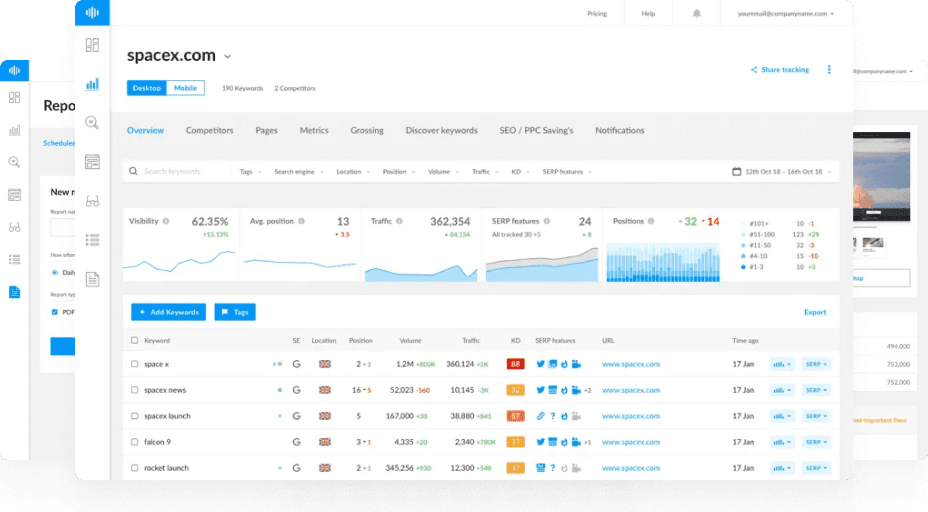

- Ranktracker Web Audit: Identifiserer skjemahull og manglende samsvar mellom entiteter.

- Søkeordfinner: Oppdag semantisk relaterte nøkkelord for kontekstrik optimalisering.

- AI-artikkelforfatter: Produser strukturert, faktabasert innhold som er egnet for både SEO og AI-motorer.

- SERP-kontroll: Overvåk AI-forsterkede søkefunksjoner og deres synlighetseffekt.

Fremtiden for LLM-optimalisering

Etter hvert som LLM-er blir grunnlaget for de fleste digitale grensesnitt - fra søk til virtuelle assistenter - vil optimalisering for dem bli like viktig som tradisjonell SEO en gang var.

Det kan du forvente å se:

- LLM-synlighetsanalyse (sporing av omtaler og siteringer).

- AI-trustscoring for web-enheter.

- Optimalisering på tvers av modeller, der én innholdsstrategi tjener flere AI-økosystemer.

Sammendrag

LLM-optimalisering er broen mellom SEO og AI. Den sørger for at innholdet ditt er strukturert, faktabasert og kontekstuelt nok til å bli hentet, sitert og klarert av store språkmodeller.

Etter hvert som AI blir det viktigste grensesnittet for oppdagelser, vil LLM-optimalisering avgjøre hvem som blir referert til - og hvem som forsvinner fra samtalen.